技术综合资讯

编程技术综合资讯,涵盖人工智能、云原生、编程语言发展趋势等热门话题。深度解析行业动态、技术变革,为开发者提供全面的技术视野与前瞻性分析。

共 14 篇

欢迎来到技术综合资讯专栏!这里汇聚了编程世界的各种热门话题,从人工智能的最新突破到编程语言的演进,从云原生技术到行业发展趋势,为您提供最全面的技术资讯。

Rust GCC 编译器后端:一条命令就能装上 rustc-codegen-gcc

rustc-codegen-gcc 正式进入 rustup nightly 组件,Linux 用户现在可以一键体验 GCC 编译 Rust 代码了。不用再自己编译,不用再折腾环境,就像给 Rust 换了个新引擎。

247GB 就能把 Kimi K2 Thinking 搬回家:Dynamic 1-bit GGUF 实操笔记

用 Unsloth 发布的动态 1-bit GGUF 量化版,让 1T 级 Kimi K2 Thinking 在消费级硬件上跑起来,含安装、下载、运行、部署和避坑指南。

Tokencake:多智能体KV缓存调度,把延迟打到 vLLM 一半以下

北航、北大、阿里提出 Tokencake,多智能体 KV Cache 框架,用时间+空间双调度、CPU 缓冲与渐进预留,在外部函数调用场景让端到端延迟相较 vLLM 降低 47%,GPU 内存利用率提升近 17%。

Claude 4.5 Sonnet 发布,号称全球最强编码模型

Anthropic 推出 Claude 4.5 Sonnet,宣称全球最强编码能力,基准测试得分 77.2%,长时运行可达 30 小时,同步发布 Claude Code 升级和全新 Agent SDK,并对比包括 Gemini 系列在内的多家主流模型。

Claude Code:这个AI编程助手,像给代码请了个24小时贴身管家

深度体验Claude Code AI编程助手,从本地运行到自然语言交互,看看这个基于Claude 4系列的工具如何改变开发者的日常工作,并附带 Gemini 3 + Claude Code 本地开发方案与实战教程链接。

AI泡沫真的来了?一位金融老司机的冷思考

面对热火朝天的AI投资狂潮,一位华尔街老兵提出了不一样的声音:我们可能正在经历一场新的技术泡沫。从电力瓶颈到监管盲区,这篇文章用大白话告诉你,AI热潮背后可能隐藏的风险。

Windows 11 25H2官方ISO终于现身,这次微软真的做了个小'修小补'版本

微软终于发布了 Windows 11 25H2 官方 ISO,虽然只是 24H2 的延续版本,但增长到 7GB 的体积让人好奇。从下载到安装,以及那些坑,这篇文章带你搞清楚这个’不算重大’的更新到底值不值得升级。

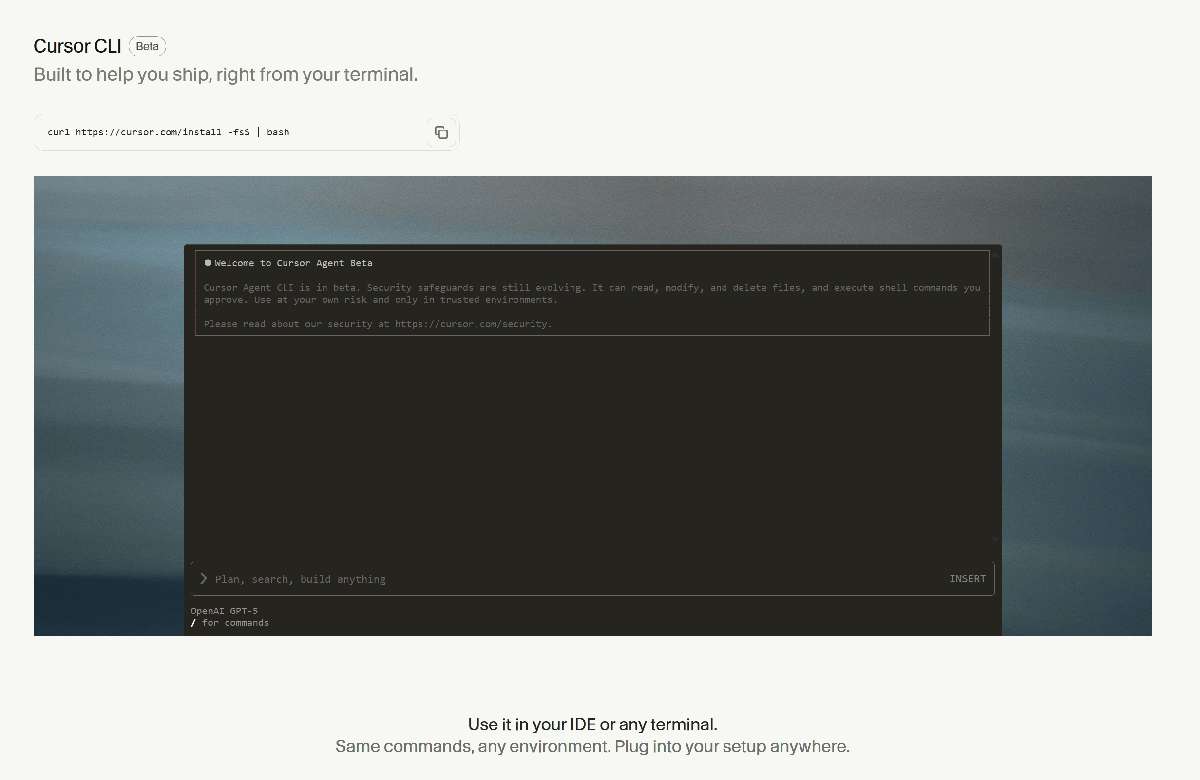

别再复制粘贴了!这个叫 Cursor CLI 的“怪物”让你在终端里和 AI 并肩作战。

告别在浏览器与终端之间来回切换!Cursor CLI 将强大的 AI Agent 注入命令行,支持聊天式生成代码、文件读写、代码审查与自动化集成(CI/CD),帮助开发者在 SSH、Vim/Neovim、本地或远程环境下保持心流、显著提升开发效率。

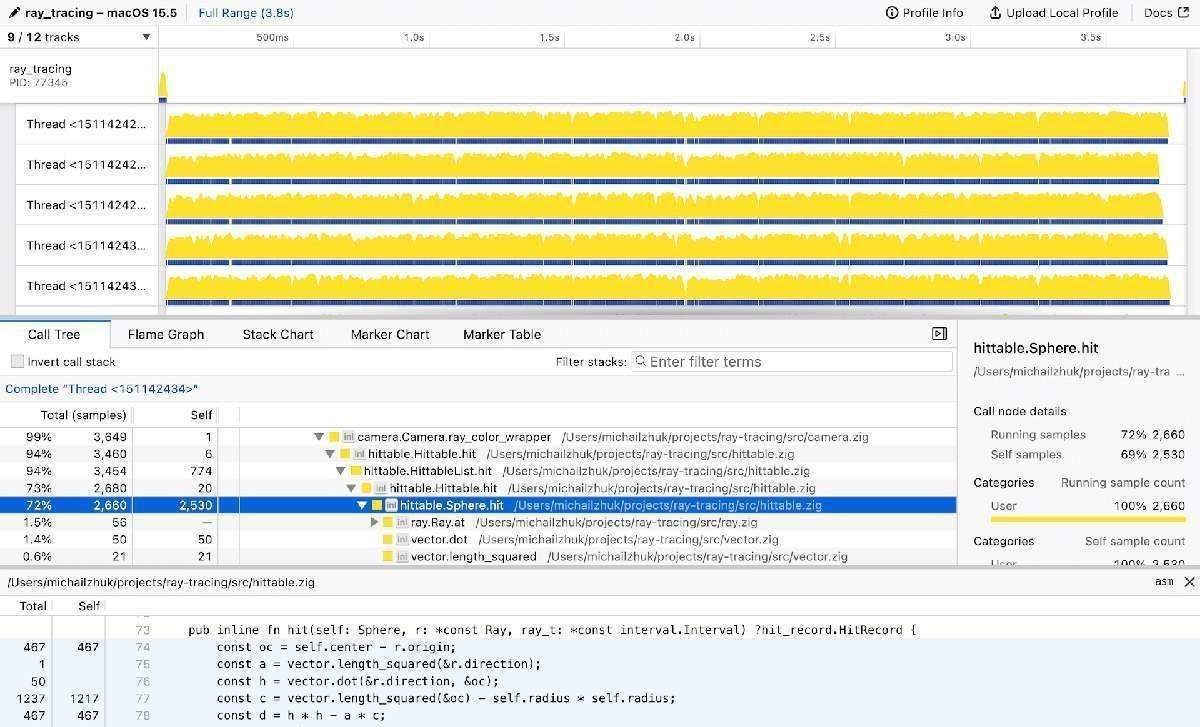

Apple Silicon (M1/M2) 上 Zig 性能分析生存指南

在 Apple Silicon (M1/M2) 上进行 Zig 性能分析可能会遇到困难,因为 perf、valgrind 等常用工具不受支持。本指南介绍了一些替代工具,如 Samply、poop 和 Tracy,帮助您在 macOS 上分析和优化 Zig 代码。

Rust后端开发者必读:为何拥抱TypeScript是你的下一个超能力

一个资深Rust后端开发者,从鄙视JS到拥抱TypeScript的心路历程。探讨Rust与TypeScript如何通过ts-rs等工具协同,打造类型安全、坚不可摧的全栈应用。