不想重写代码?用Rust边车干掉40%内存占用,这招太妙了

重写的诱惑,谁没有过

每个程序员心里都住着一个"重写狂魔"。

看着老系统那一坨糊成一团的代码,总有个声音在耳边嘀咕:要不咱全部推翻,用Rust重写一遍?内存安全、性能爆炸、p99延迟直接起飞。

说实话,这种想法我也有过。尤其是当你看着监控面板上内存曲线像过山车一样上上下下,GC暂停时不时来个几十毫秒的"小惊喜",你就特别想掀桌子。

但是,真的要重写吗?

重写是一场豪赌

重写这事儿,说起来容易做起来难。你以为是给房子重新装修,其实是要把房子拆了重盖。

工期预估三个月,实际干了一年半。需求在变,团队在换,写到一半发现原来系统里那些"看不懂的代码"其实都有道理。

更要命的是,老系统还得照常跑着,新系统还没上线,你就得两边维护。这感觉就像一边开着车一边换轮胎,刺激是刺激,就是容易翻车。

所以我今天想聊的是另一条路:不重写,但是偷偷让Rust帮你干活。

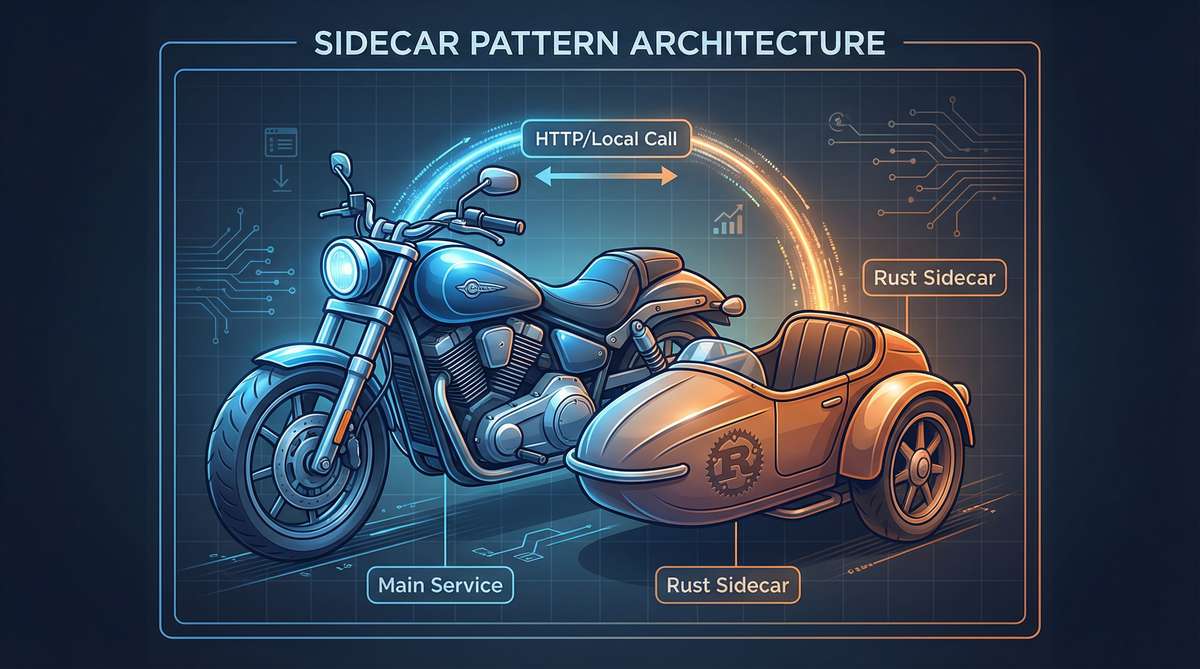

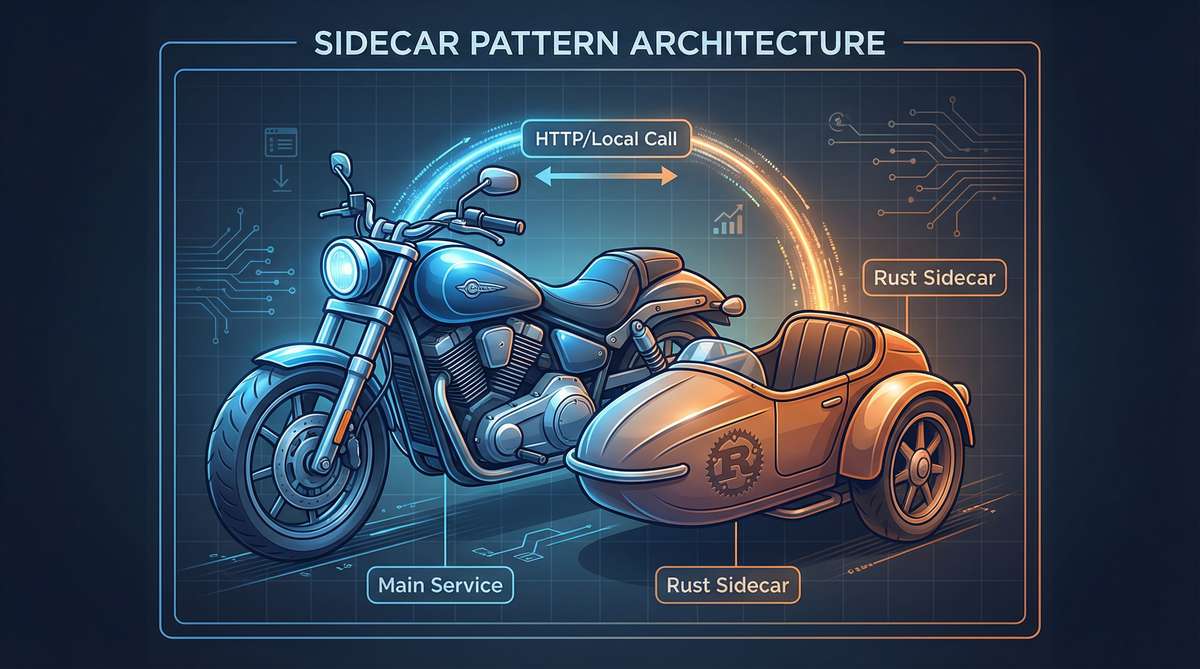

Sidecar边车模式:找个帮手分担脏活

边车这个词儿,Sidecar,听起来有点怪。但你想想那种挂在摩托车旁边的小斗斗,有人坐在里面,跟着主车一起跑,但又相对独立。这就是Sidecar边车模式的核心思想——不重构,而是让Rust Sidecar帮你做内存优化的脏活。

在软件架构里,边车就是这么个意思:你的主服务还是老样子,但旁边跑一个小服务,专门帮你处理某些特定任务。

[你的老系统]

|

| 本地调用

v

[Rust边车:压缩/校验/格式化]

这个小服务可以用Rust写。它就跟主服务部署在一起,通过本地HTTP或者Unix Socket通信。延迟低得可以忽略,但好处是你把CPU密集的脏活都甩出去了。

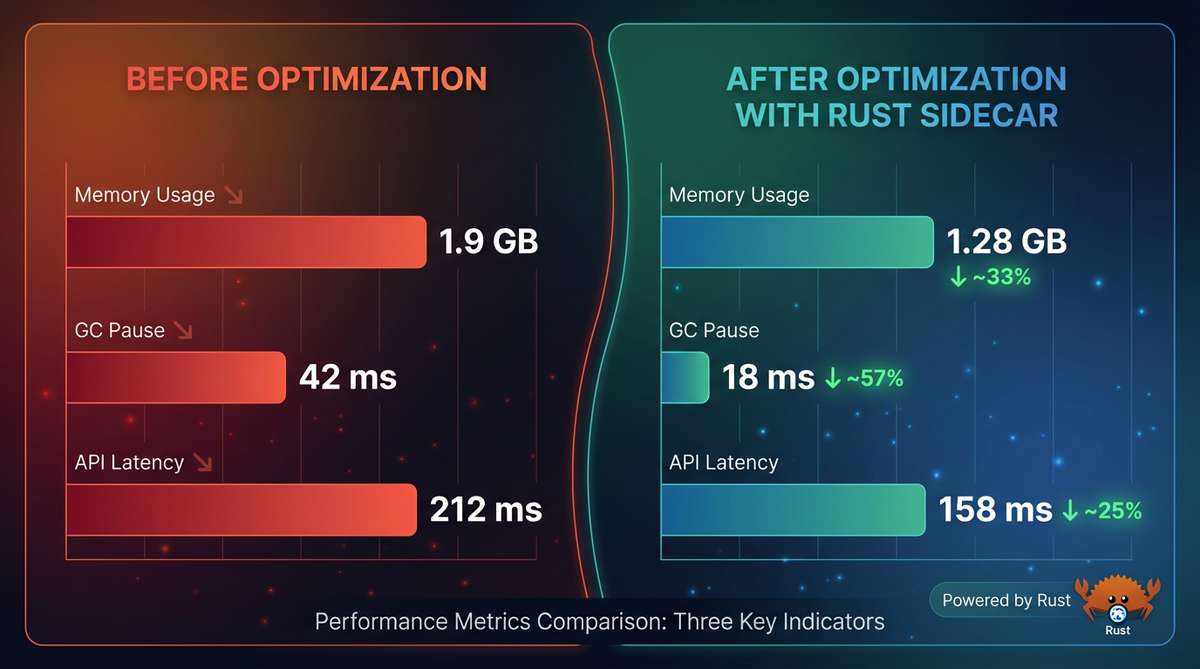

Rust Sidecar实战效果:内存优化40%

来看一组真实数据。

有个团队把最热的路径——数据格式化、校验、压缩——从主服务剥离到Rust边车里。就这么一个操作,效果立竿见影:

| 指标 | 改造前 | 改造后 |

|---|---|---|

| 主服务内存 | 1.9 GB | 1.1 GB |

| 边车内存 | - | 180 MB |

| 总内存 | 1.9 GB | 1.28 GB (降了32%) |

| GC暂停 p95 | 42 ms | 18 ms |

| 接口延迟 p95 | 212 ms | 158 ms |

你看这数字,主服务的内存直接从1.9G掉到1.1G。虽然多了个边车占180M,但总体算下来还是省了六七百兆。

更关键的是GC暂停时间。从42毫秒降到18毫秒,这对用户体验的提升是实打实的。少了那些时不时的卡顿,用户才不会觉得你的系统"有点慢"。

哪些活儿适合外包给边车?

不是什么活都适合往外甩的。

你想啊,边车最擅长的是那种"闷头干活"的任务。比如数据压缩解压,gzip、brotli这些,CPU一顿猛算就完事了。再比如JSON校验、Protobuf解析,或者签名验证、哈希计算这类加密操作。还有图片缩放、生成缩略图,日志里用正则扒数据,简单的评分计算什么的。

这些任务有个共同点:给它输入,它吭哧吭哧算一通,吐出结果,中间不需要问东问西。就像你请了个临时工帮忙搬砖,砖在这儿,搬到那儿,不需要知道你家整体装修方案是啥。

但有些活儿就不适合甩出去了。

比如动不动就要查数据库的,或者大部分时间都在等网络响应的,这种瓶颈根本不在CPU,甩出去也没用。还有那种需要维护复杂会话状态的,或者要处理超大文件流的,这些跟边车的"无状态单次调用"模式天然不合。硬塞进去,反而多了一层网络开销,得不偿失。

来看看代码长啥样

用Rust写一个简单的边车服务,其实代码量很少。比如一个处理文本格式化和压缩的服务:

use axum::{routing::post, Router, Json};

use serde::{Deserialize, Serialize};

use flate2::{write::GzEncoder, Compression};

use std::io::Write;

#[derive(Deserialize)]

struct Input {

text: String

}

#[derive(Serialize)]

struct Output {

ok: bool,

bytes: usize,

compressed: Vec<u8>

}

async fn normalize(Json(input): Json<Input>) -> Json<Output> {

// 简单的格式化:去空格、转小写

let clean = input.text.trim().to_lowercase();

if clean.is_empty() {

return Json(Output { ok: false, bytes: 0, compressed: vec![] })

}

// 压缩

let mut encoder = GzEncoder::new(Vec::new(), Compression::fast());

encoder.write_all(clean.as_bytes()).ok();

let body = encoder.finish().unwrap_or_default();

Json(Output { ok: true, bytes: clean.len(), compressed: body })

}

#[tokio::main]

async fn main() {

let app = Router::new().route("/process", post(normalize));

let listener = tokio::net::TcpListener::bind("127.0.0.1:8081").await.unwrap();

axum::serve(listener, app).await.unwrap();

}

你的主服务只需要往 127.0.0.1:8081/process 发POST请求就行了。数据在本地走一圈,延迟基本可以忽略。

为什么这招管用?

可能你会问:不就是多了一个服务吗,怎么内存就省了这么多?

原因在于堆隔离,这也是内存优化的关键。

像Java、Python、Node这些有GC的语言,处理请求时会在堆上分配大量临时对象。这些对象用完就扔,但GC需要花时间去清理它们。数据量一大,GC压力就上来了。这就是为什么需要进行内存优化。

把这部分工作挪到Rust边车里,这些临时内存就不在主服务的堆上分配了。Rust自己管理内存,用完立马释放,不需要等GC来扫。这种内存优化方式效果非常明显。

这就像你家里垃圾桶老是满,你不是买个更大的垃圾桶(加内存),也不是请人更频繁地倒垃圾(调GC参数),而是把产生垃圾最多的工作外包出去,让别人在他自己地方处理。你家垃圾自然就少了。这就是Sidecar模式的内存优化原理。

边车的几个实操要点

真要上手搞边车,有几个细节得注意。

通信方式的话,本地HTTP够用了。如果你追求极致,可以用Unix Socket,省掉TCP握手那点开销,不过说实话大部分场景HTTP就够了,别过早优化。

超时一定要设。给每个调用卡个20毫秒的上限,边车要是挂了或者卡住了,别把主服务也拖下水。限流和熔断也得有,边车过载就让它返回429,主服务那边做好降级,该走老逻辑就走老逻辑。

回滚机制这个太重要了,必须得有。用feature flag控制流量走向,出问题了改个配置就能切回去,不用重新部署。这种"随时能撤"的设计,才是你敢往生产环境上新东西的底气。

日志和监控也别偷懒。每个请求至少记个trace_id、输入输出大小、耗时、状态码。真出问题了,这些数据能救命。

说说实际能拿到的好处

用边车这招,好处其实挺多的。

首先就是堆隔离,主服务的GC终于不用追踪那些临时大对象了,清理压力一下子小了很多。延迟也跟着稳了,Rust那边内存用完就释放,不存在"等GC心情好了再清理"这种事,p95自然就平稳了。

内存省下来之后,同样的机器能扛更多流量,这账谁都会算。主服务瘦身了,冷启动也快了不少。

还有个特别实用的点:回滚太方便了。改个配置就能把流量切回主服务处理,不用重新部署,出了问题几分钟就能撤。这种"随时能跑"的底气,才是敢于尝试新东西的前提。

监控也好看了,一个服务一个堆,哪边出问题图上一目了然,不用在一堆混杂的指标里猜来猜去。

还有一点你别笑——这招在公司里推起来阻力小。你跟老板说"我们要用Rust重写系统",他可能当场脸就绿了。但你说"我们加个小工具帮忙处理一下",那完全是另一回事。

什么时候该用边车,一张决策图

这个任务是CPU密集的吗?

|

是 -> 输入输出大小可控吗?

|

是 -> 可以做成无状态的单次调用吗?

|

是 -> 试试边车吧

否 -> 留在主服务

否 -> 留在主服务

否 -> 留在主服务

简单说,满足三个条件就可以考虑边车:CPU密集、数据量可控、无状态。

边车不是银弹

当然了,边车也不是万能的。

数据在两个服务之间传来传去,序列化开销是躲不掉的。虽然本地调用很快,但毕竟比函数调用多了一层。另外你多了一个进程要运维,虽然简单,但监控、部署、排障的时候总归多了个东西要看。团队里也得有人能看懂Rust代码,出了问题总不能对着边车干瞪眼。

还有一点要提醒:别上头。边车处理的应该是"体力活",核心业务逻辑还是放在主服务里。我见过有人尝到甜头之后,恨不得把什么都往边车里塞,最后系统变成一堆小服务的集合,那就是另一种形式的"重写"了,还不如一开始就老老实实重写呢。

最后说两句

下次当你盯着系统监控,看着内存曲线蹭蹭往上涨,GC时不时来个大扫除的时候,别急着喊重写。

先问问自己:有没有哪个CPU密集的热点路径,可以单独拎出来让Rust帮忙处理?

不需要动大手术,也不用说服全公司换技术栈。就一个小服务,跑在旁边,帮你分担最重的那部分活。

省下40%内存,降低一半延迟,万一出问题几分钟就能回滚。

这买卖,怎么算都不亏。

FAQ(常见问题)

Q:Rust Sidecar和微服务有什么区别? A:边车和主服务部署在同一个容器/POD里,通过本地调用通信。微服务是独立部署的独立服务,通常有网络通信开销。

Q:边车模式的延迟开销有多大? A:本地HTTP调用通常增加0.5-2毫秒的延迟。用Unix Socket可以降到1毫秒以内。对于节省几百毫秒的CPU密集型任务来说,这点开销可以忽略。

Q:哪些语言的主服务适合搭配Rust边车? A:Java/Python/Node这类有GC压力的语言收益最大。Go这种内存管理本就不错的语言,改善可能没那么明显。

如果你对Rust的其他性能优化技术感兴趣,可以看看这些文章:

- 从800ms到90ms:Rust的Rayon库如何拯救了我的多线程噩梦 - 并行计算优化

- Rust mmap内存映射IO - 文件读取性能优化

- io_uring入门:用Rust打造高性能服务器 - 异步IO优化

左下角查看原文

如果这篇文章对你有帮助,欢迎点赞、转发、收藏三连。关注我,后续还会分享更多系统优化和Rust实战经验。

有问题可以在评论区留言,我们一起讨论。