别再吹 WebAssembly 了,WebGPU 才是真正的性能革命

WebGPU 性能实测:23 倍提升的真实数据

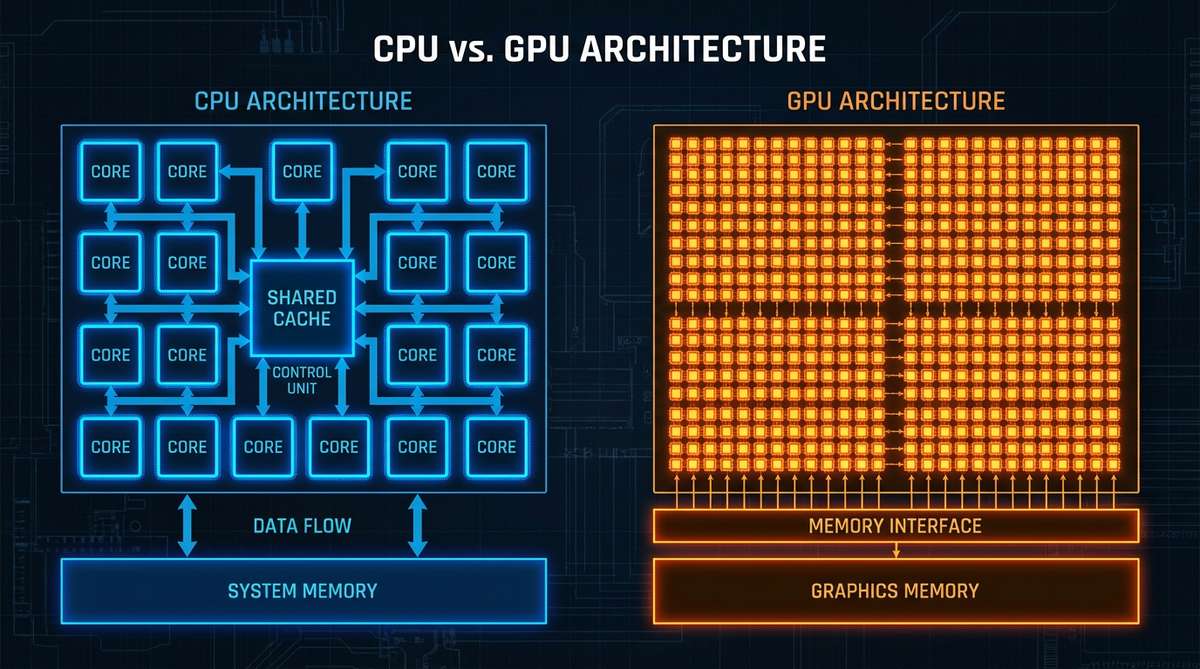

上个月,我花了三天时间优化一个数据可视化项目,5 万个数据点把页面卡得像 PPT。我已经用 Rust 重写了核心逻辑,编译成 WebAssembly,性能提升了 40%,心里还挺美的。

然后,出于好奇(好吧,其实是绝望),我用 WebGPU 重写了渲染循环。

结果?快了 23 倍。

不是 23%,是 23 倍。这个数字让我反复检查了好几遍,确认没测错之后,我开始怀疑自己这几个月是不是在解决一个错误的问题。

我们一直在自欺欺人

整个开发者社区都在吹 WebAssembly 是 Web 性能的未来,但 WebGPU 已经悄悄在 Chrome、Safari 和 Firefox 里上线了。而且它不只是让图形渲染更快——它正在从根本上改变浏览器能做什么。

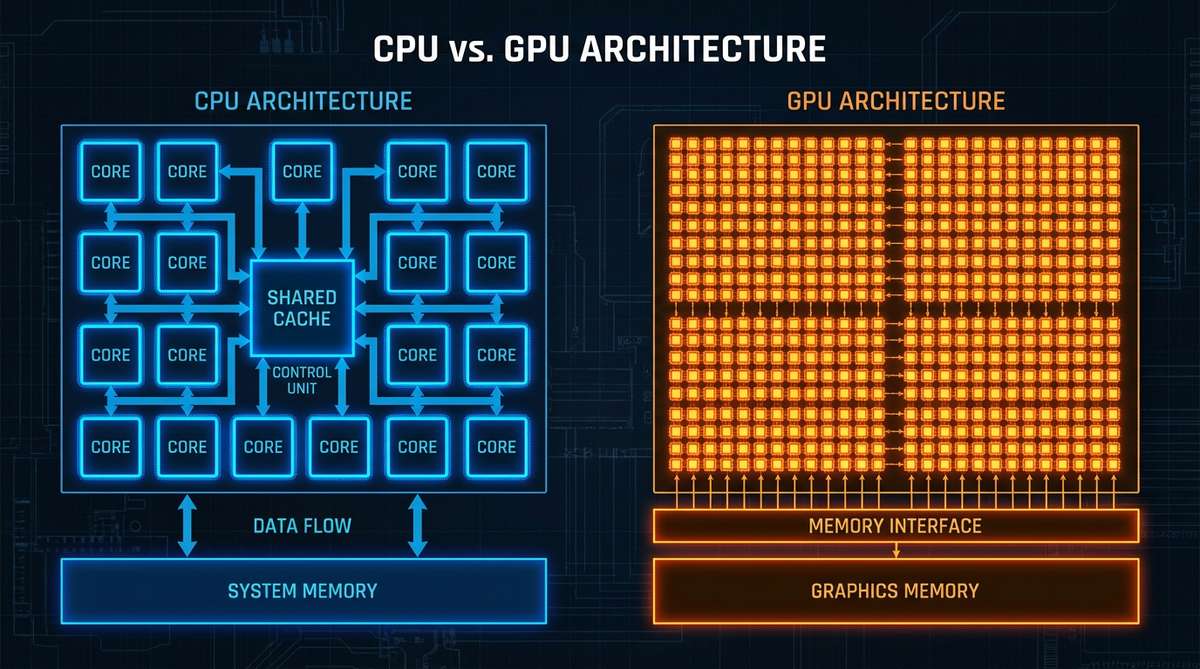

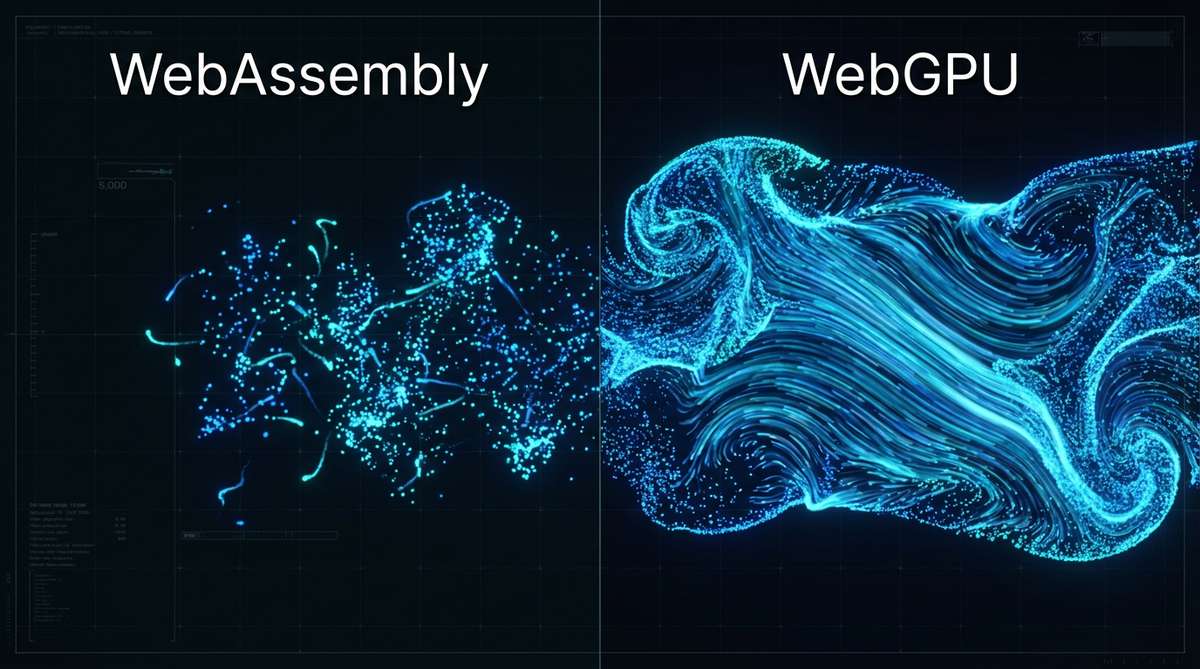

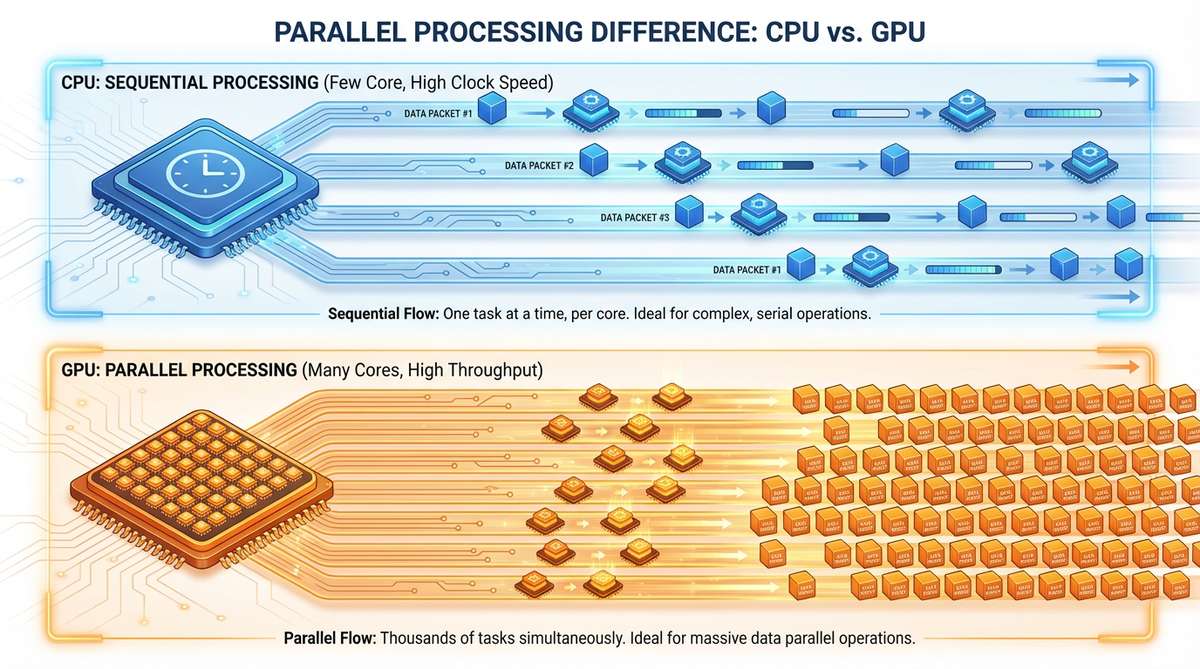

我们一直告诉自己一个安慰性的谎言:CPU 性能是 Web 应用的瓶颈。所以我们优化 JavaScript,用 TypeScript 写更好的代码,实在不行就上 WebAssembly 榨干 CPU 的每一个周期。

但你仔细想想,你的电脑里有一块超级强大的 GPU,每秒能执行万亿次运算,我们却只用它来渲染圆角和阴影?

现实是,对于大多数计算密集型任务——图像处理、物理模拟、机器学习推理、数据转换——GPU 比 CPU 强几百倍。WebGPU 终于让我们能在浏览器里用上这股力量了。

WebGPU 是什么:浏览器里的 GPU 计算引擎

WebGPU 是 W3C 标准化的现代图形和计算 API,允许 JavaScript 直接访问 GPU 进行高性能并行计算。与 WebGL 不同,WebGPU 从设计之初就同时支持图形渲染和通用计算(GPGPU),可实现 10-100 倍的性能提升。

WebGPU 的核心优势:

- 直接访问 GPU 的数千个计算核心

- 支持通用计算,不仅限于图形渲染

- 现代 API 设计,更接近 Vulkan/Metal/DirectX 12

- 主流浏览器已支持(Chrome、Safari、Edge、Firefox)

WebGPU 让你能用 JavaScript 直接控制 GPU。你可以把它理解成:写程序让显卡干活,而不是让 CPU 干活。

WebGPU 代码示例:从 CPU 到 GPU 的转变

CPU 处理方式(WebAssembly)

// CPU 方式 - 最多用上 8-16 个核心

function processData(input) {

const output = new Float32Array(input.length);

for (let i = 0; i < input.length; i++) {

output[i] = Math.min(Math.max(input[i] * 2 + 10, 0), 100);

}

return output;

}

用 WebGPU,你写一个着色器,让几千个 GPU 核心同时干活:

const shaderCode = `

@group(0) @binding(0) var<storage, read> input: array<f32>;

@group(0) @binding(1) var<storage, read_write> output: array<f32>;

@compute @workgroup_size(64)

fn main(@builtin(global_invocation_id) id: vec3<u32>) {

let i = id.x;

output[i] = clamp(input[i] * 2.0 + 10.0, 0.0, 100.0);

}

`;

WebGPU vs WebAssembly 性能对比

| 特性 | WebGPU | WebAssembly |

|---|---|---|

| 计算单元 | GPU (数千核心) | CPU (8-16核心) |

| 并行能力 | 大规模并行 | 有限并行 |

| 典型提升 | 10-100倍 | 2-3倍 |

| 适用场景 | 数据处理、图像、模拟 | 算法、移植、沙箱 |

| 学习曲线 | 中等 | 较低 |

| 浏览器支持 | Chrome/Safari/Edge | 全部主流浏览器 |

WebGPU 三大应用场景

WebGPU 最适合以下类型的应用:

1. 大规模数据可视化

处理数万到数百万数据点的实时渲染,包括:

- 客户端数据处理:我们做了一个仪表盘,要聚合和过滤物联网传感器的时序数据。以前每次改筛选条件都要请求后端,因为在 JavaScript 里处理 2GB 数据慢得离谱。把聚合逻辑搬到 WebGPU 着色器之后,现在完全在客户端跑,筛选响应不到 50 毫秒。后端成本直接降了 60%,因为只需要传一次原始数据。

2. 实时图像处理与 AI 推理

不只是加滤镜的小打小闹,而是真正的专业应用:

- 医学图像分析:CT 扫描、MRI 图像的实时处理

- 卫星数据处理:遥感图像的实时分析和渲染

- 质量检测系统:有个朋友的团队做了一个缺陷检测系统,实时分析工厂摄像头画面。以前用云端 ML API,按帧收费。把推理搬到 WebGPU 之后,完全在浏览器里跑。零延迟,零 API 费用。

- 浏览器端 AI 模型推理:TensorFlow.js、ONNX.js 的 GPU 加速

3. 物理模拟与粒子系统

需要大量并行计算的模拟场景:

- 流体动力学:我们给一个教育平台做流体动力学可视化原型。WebAssembly 版本最多撑 5000 个粒子,再多就卡成幻灯片。WebGPU 版本?50 万个粒子,60 帧流畅运行。

- 粒子系统:游戏中的烟花、烟雾、水流效果

- 碰撞检测:物理引擎中的大规模碰撞计算

- 加密计算:哈希计算、加密解密操作

WebGPU 适用场景总结

- 大规模数据可视化 - 处理数万到数百万数据点的实时渲染

- 客户端数据处理 - 在浏览器中完成 GB 级数据的聚合和过滤

- 实时图像处理 - 医学图像分析、卫星数据处理、质量检测

- AI 推理 - 在浏览器中运行机器学习模型

- 物理模拟 - 流体动力学、粒子系统、碰撞检测

- 加密计算 - 哈希计算、加密解密操作

规律很明显:任何涉及大数据集并行操作的问题,都能变得飞快。

为什么这比 WebAssembly 更重要

WebAssembly 本来应该是伟大的均衡器。把你的 C++/Rust 代码编译一下,在浏览器里跑,获得接近原生的性能。对于 CPU 密集型任务,它确实做到了。

但那些 WebAssembly 吹文从来不提的是:你还是被 CPU 核心数限制着。就算你完美地把 WebAssembly 代码并行化到所有可用线程(这其实很难),高端笔记本也就 8-16 个核心。你的 GPU 有几千个。

我不是说 WebAssembly 没用。它在某些场景下很棒——移植现有原生应用、运行 CPU 密集型算法、沙箱执行。但"WebAssembly 是 Web 性能的未来"这个说法,在你意识到 GPU 计算存在之后,就显得不完整了。

争议性观点?WebAssembly 可能其实是个干扰项。它是一个渐进式改进,给我们 2-3 倍的提速,让我们觉得性能问题解决了。与此同时,WebGPU 在那儿提供 10-100 倍的提速,大多数开发者却看都不看,因为"那是搞图形的人用的"。

学习曲线确实存在,但值得

我不会骗你说 WebGPU 很容易上手。API 很啰嗦,你得理解缓冲区绑定布局、管线状态这些概念,调试着色器代码会让你怀念 console.log。

第一次尝试从 JavaScript 往着色器传数据,我花了很长时间才搞明白。你不能直接把 JavaScript 数组扔给 GPU——你得创建缓冲区、设置绑定组、考虑内存对齐、理解 uniform 缓冲区和 storage 缓冲区的区别。

但复杂是有原因的。WebGPU 给你对 GPU 内存和执行的精确控制,这正是巨大性能提升的来源。用便利换力量。

说实话,学习曲线被夸大了。如果你能理解 async/await 和 Promise,你就能理解 WebGPU 管线。只是不一样,不是更难。给自己一个周末看看文档和示例,基础就能掌握。

WebGPU 学习路线:从入门到实战

第一步:基础知识准备

- 理解 GPU 并行计算原理

- 学习基本的线性代数知识

- 熟悉 JavaScript 的异步编程

第二步:WebGPU 基础概念

- 设备初始化:获取 GPU 设备

- 缓冲区管理:创建和使用内存缓冲

- 着色器编程:学习 WGSL 语言基础

- 管线配置:理解渲染和计算管线

第三步:实战项目

- 简单的数据处理:数组变换、排序算法

- 图像处理:滤镜、边缘检测

- 粒子系统:基础物理模拟

- 数据可视化:大规模数据集渲染

WebGPU 浏览器支持现状(2025年)

- Chrome/Edge:完全支持

- Safari:完全支持(macOS Monterey+)

- Firefox:支持(需要启用

dom.webgpu.enabled标志) - 移动端:Android Chrome 支持,iOS Safari 部分支持

推荐学习资源

WebGPU 开发工具和库

原生 WebGPU API

直接使用浏览器提供的 WebGPU API,适合学习和深度定制。

封装库推荐

- Three.js:3D 图形库,已支持 WebGPU 渲染器

- Babylon.js:微软的 3D 引擎,完整的 WebGPU 支持

- wgpu:Rust 的 WebGPU 实现

- dawn:Google 的 WebGPU 实现(C++)

什么时候该用 WebGPU

适合 WebGPU 的场景:

- 需要处理 10,000+ 数据点的可视化

- 实时 处理图像或视频

- 运行 物理模拟 或粒子系统

- 在浏览器中执行 机器学习推理

- 需要 cryptographic 计算或 密码学操作

不适合 WebGPU 的场景:

- 简单的 CRUD 应用

- 表单处理和验证

- 小型 UI 动画

- 传统网站内容展示

总结

WebGPU 不是万能药。CRUD 应用、静态网站、表单不需要它。但如果你在做任何处理大量数据、渲染复杂可视化、或者对大数据集重复计算的东西——值得研究一下。

从小处开始。找你应用里的一个性能瓶颈,看看它是不是适合 GPU 计算。那些"尴尬并行"的问题(每个输出只依赖它的输入)最容易出效果。图像滤镜、数据转换、粒子系统、模拟。

工具链还年轻,但进步很快。Three.js 和 Babylon.js 已经集成了 WebGPU 支持。框架作者们开始关注了。浏览器支持已经到位——Chrome、Edge、Safari 都发布了,Firefox 在实验标志后面。

真正的转变不是技术上的——是思维上的。我们得停止把 GPU 当成"那个渲染图形的东西",开始把它看成一个恰好存在于我们发布代码的每台设备里的大规模并行计算引擎。

如果你对 CPU 并行计算 感兴趣,可以看看 Rust Rayon 多线程优化实战 ,了解如何在 CPU 端进行并行优化。

最后的真相

我们花了好几年优化 JavaScript,然后用 TypeScript 提高可维护性,然后用 WebAssembly 追求性能。这些都有用。但它们也在解决一个根本上有限的问题:怎么从顺序 CPU 执行中榨出更多性能。

WebGPU 不会让 JavaScript 更快。它不会让 WebAssembly 过时。它做的是让一整类问题变得轻而易举——那种你以前会说"这得用后端"或"得用原生代码"的问题。

如果说 WebAssembly 是把桌面性能带到 Web,WebGPU 就是把超算性能带到 Web。这不是吹牛,这是数学——现代 GPU 每秒能执行的操作比几年前的 CPU 集群还多。

所以,WebAssembly 该用还是用。但别再忽视 WebGPU 了。因为下一代 Web 应用不会是我们今天做的东西的更快版本——它们会是我们现在觉得在浏览器里不可能实现的东西。

你的应用里最耗计算的是什么?你有没有想过,它可能跑在了错误的硬件上?

如果这篇文章对你有帮助,别忘了点赞、转发、收藏三连支持一下。有什么想法或者问题,欢迎在评论区聊聊。关注我,后续会带来更多前端性能优化的干货内容。