3 步 0 成本接入 2000 tokens/s 模型,让 Claude Code 起飞(Cerebras × Cloudflare)

先把话放在前面:今天这事,值回票价。你不需要掏一分钱的月费,就能把“全球最快”的编程大模型接进来,推动 Claude Code 像加了涡轮一样干活。思路很简单:用 run.claw.cloud 一键部署网关,接 Cerebras 的免费额度,把通道暴露成 OpenAI 兼容接口,前端工具直接用就行。

为什么要这么干?一句话,速度和成本。Cerebras 背后是整套推理加速栈,像给电动车接上特斯拉超充;Claude Code 做的是“驾控体验”,你只要给它接一条又快又稳的“油路”,它就能飞。以前卡在“贵”和“慢”,现在这套组合拳能把门槛打穿。

如果你完全不会 Node,也没关系,照着做就能跑起来。不过有一点小提示:命令行要会复制粘贴就够了。

环境准备(Claude Code + Cerebras + Cloudflare Workers)

macOS 装 Node 最省心的方式是 Homebrew。跑下面两行就好:

brew install node

npm install -g @anthropic-ai/claude-code

Windows 朋友建议先装 WSL 的 Ubuntu,再在 Ubuntu 里装 Node 和 CLI:

sudo apt update && sudo apt install -y nodejs npm

npm install -g @anthropic-ai/claude-code

装好以后先别急着用,我们把“油路”打通。

三步打通 OpenAI 兼容通道(run.claw.cloud + Cerebras)

第一步,去 Cerebras 注册并拿一个免费的 API Key。搜索 cerebras.ai,注册后在控制台里就能生成。它提供 OpenAI 兼容的推理接口,核心型号里有 Qwen-3-Coder-480B,速度拉满。

请求速率限制:每分钟最多 30 次请求,每小时最多 900 次请求。

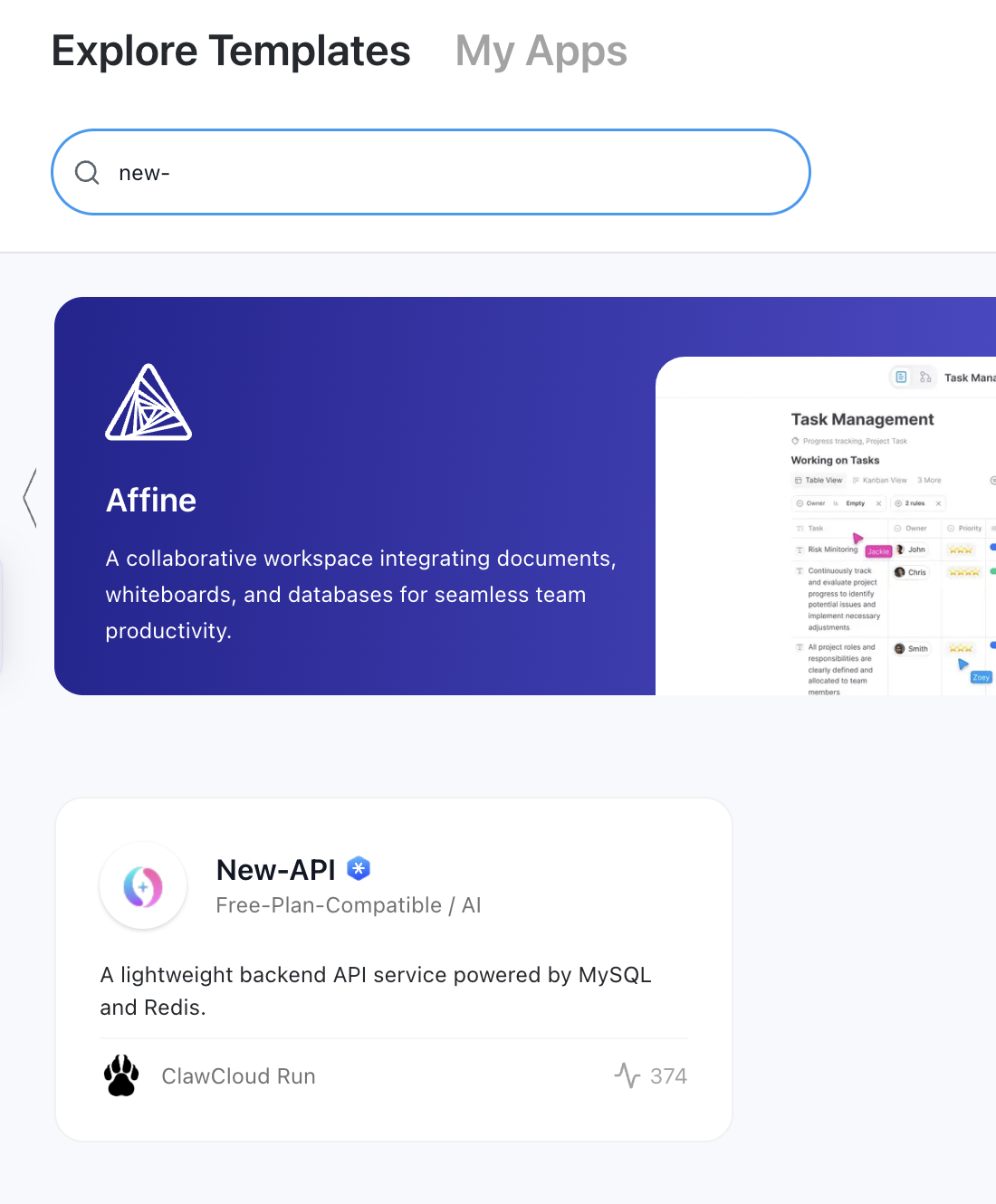

第二步,打开 run.claw.cloud 的控制台,https://console.run.claw.cloud/signin?link=IY4OLFYXS3WY ,登录进去后进应用商店搜索 new-api,一键部署。这个网关会自动给你分配一个域名,形如 your-app.run.claw.cloud。首次访问会让你设置管理员账户和密码,按提示来就行,注意有些环境对账户长度有小限制,取个短一点的名字更稳妥。

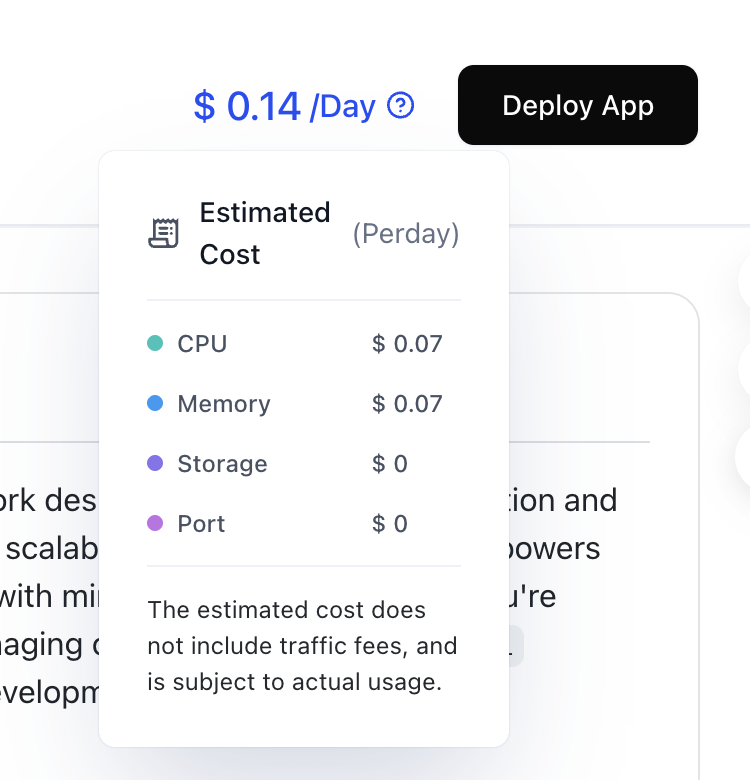

若用180 天以上 GitHub 账号可每月领5刀额度,可以跑一个n8n服务。

第三步,进入你新部署的后台,找到“通道管理”。添加一个通道,名称随便,类型选 OpenAI。Base URL 写 https://api.cerebras.ai

,密钥填你在 Cerebras 控制台拿到的 API Key。保存后把这个通道设为可用。到这里,后面的任何 OpenAI 风格的请求,走你自己的网关,就会被安全地转给 Cerebras。

部署 claude-worker-proxy(可选:进一步加速与稳定)

- 注册cloudflare并安装wrangler:https://developers.cloudflare.com/workers/wrangler

- 下载开源项目https://github.com/glidea/claude-worker-proxy

git clone https://github.com/glidea/claude-worker-proxy

cd claude-worker-proxy

npm install

wrangler login

- 运行 npm run deploycf,记录 Worker 地址:https://claude-worker-proxy.your-subdomain.workers.dev。

接入 Claude Code(自定义 OpenAI 兼容接口)

Claude Code 支持走自定义的 OpenAI 兼容接口。你只需要把它的接口地址指向刚才部署出来的域名,然后照常选模型、写代码就好。思路就像“家里的净水器接自来水”,Claude Code 不关心水厂是哪家,它只要水干净、压力够。

~/.claude/settings.json

{

"env":{

"ANTHROPIC_BASE_URL":"https://claude-worker-proxy.your-subdomain.workers.dev/openai/https://your-app.run.claw.cloud/v1",

"ANTHROPIC_API_KEY":"sk-your-new-api-token",

"ANTHROPIC_MODEL":"qwen-3-coder-480b",

"ANTHROPIC_SMALL_FAST_MODEL":"gpt-oss-120b",

"API_TIMEOUT_MS":"300000"

}

}

如果你想用命令行先测一把通道是否畅通,可以用 curl 试一下。下面是一个标准的 OpenAI Chat Completions 调用,把域名、密钥和模型名替换成你自己的:

curl https://your-app.run.claw.cloud/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_PROXY_KEY_OR_CEREBRAS_KEY" \

-d '{

"model": "qwen-3-coder-480b",

"messages": [

{"role": "user", "content": "用 Node 写一个读取目录的脚本,并附上错误处理"}

]

}'

如果返回了正常的 JSON,就说明通道没问题。把同样的地址和密钥配置到你的编辑器或 Claude Code CLI 里,一切工作流都能无缝继续。

常见报错与性能优化

有时候你会遇到 401 或 403,大概率是密钥写错、域名没带 /v1,或者模型名拼写不对。逐一排查,基本都能解决。还有一个“隐形开关”是超时,你可以把客户端的超时时间稍微放大一点,尤其是让模型写大段代码的时候,别太激进。并发建议循序渐进,先跑顺一条,再慢慢加压,就像热车一样,别一脚地板油。

价值与可扩展性

从体验层面讲,你获得的是“Claude Code 的顺手 + Cerebras 的推理速度”。从钱包层面讲,你把“按次计费”换成了“合理使用免费额度”,日常写业务代码完全够用。更大的价值是这是一条可替换的“油路”,以后你想接 OpenRouter、想切别的 OpenAI 兼容服务,基本都是同样的接线方式,工具链无需重练。

最后给一句“开箱即用”的心法:别把它当黑魔法,它就是一条高速公路。路修平了,车自然跑得快。

关注梦兽编程微信公众号,解锁更多黑科技